Matemáticos de RUDN University descubrieron cómo reducir una red neuronal 6 veces sin sobreajuste

El principio de los dispositivos de redes neuronales artificiales repite la organización de las neuronas en un organismo vivo: los nodos están conectados con «vecinos», algunos de ellos transmiten una señal, activando o inhibiendo el siguiente elemento de la cadena, y algunos la reciben. El procesamiento de cualquier señal, ya sea imagen o sonido, requiere una gran cantidad de elementos de red y conexiones que parten de ella. Además, en los ordenadores existe una limitación en relación con la potencia, así como con la cantidad de memoria del dispositivo. Cuando se trabaja con grandes cantidades de datos, los expertos recurren a trucos para reducir la capacidad requerida. Uno de ellos es la denominada cuantificación, la cual permite reducir los recursos consumidos, pero al mismo tiempo requiere un sobreajuste del sistema. Sin embargo, unos matemáticos de RUDN University descubrieron que el sobreajuste se puede evitar.

«Hace algunos años, estudiamos de qué manera cuantificar los pesos de manera eficiente y rentable en una red de Hopfield. Esta es una red de memoria asociativa, cuyas conexiones son simétricas y se forman según la regla de Hebb. La actividad de la red durante el proceso de trabajo concurre a un determinado estado de equilibrio, que al ser alcanzado, se considera que se ha encontrado la solución al problema. Nosotros hemos aplicado estos estudios en redes neuronales de distribución directa que son las más populares actualmente para el reconocimiento de imágenes. Por lo general, después de cuantificar tales redes es necesario un sobreajuste, pero descubrimos cómo evitarlo» dijo Iakov Karandashev, Doctor en Ciencias Físico-Matemáticas, profesor del Instituto Matemático S. M. Nikolskiy, RUDN University.

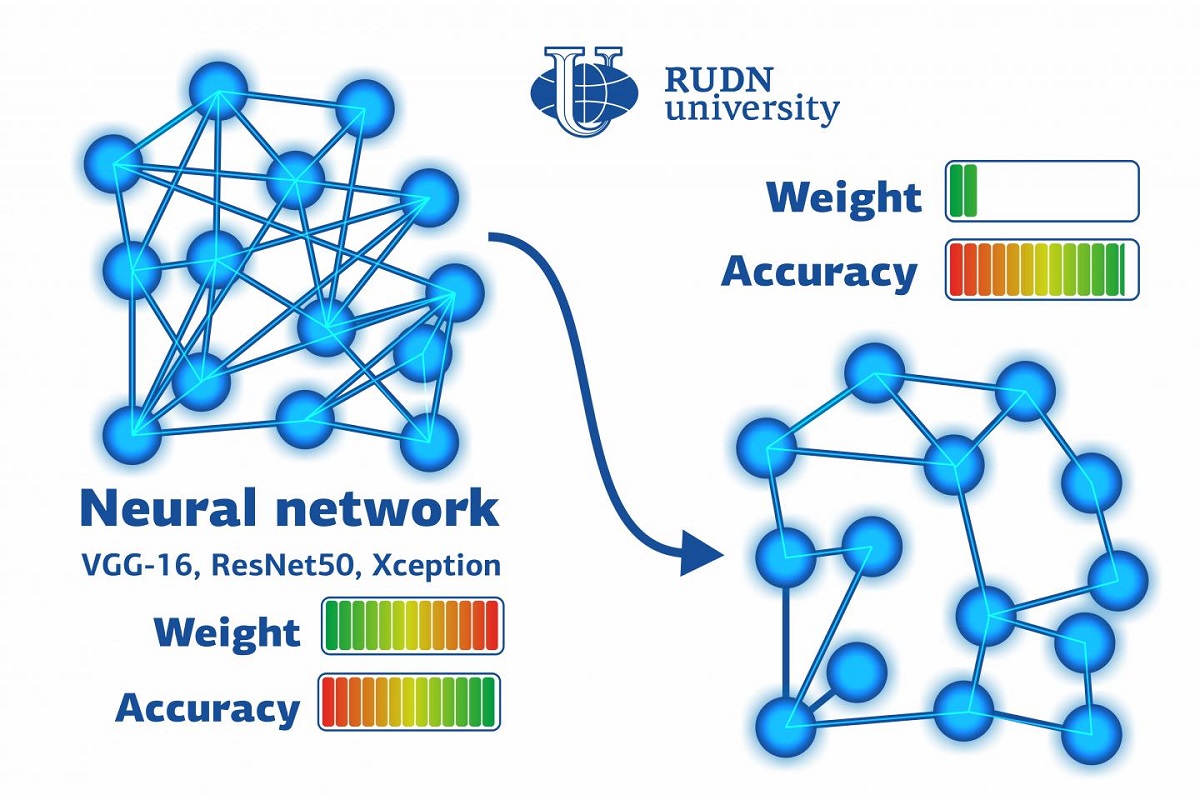

La idea principal detrás de la simplificación de las redes neuronales artificiales es reducir la cantidad de bits por peso, es decir, la cuantificación de pesos. La cuantificación implica promediar una señal, por ejemplo, en el caso de las imágenes, los píxeles de los tonos de un mismo color se volverían iguales. Matemáticamente, esto significa que las conexiones neuronales que son similares en algunos parámetros tendrán el mismo peso o importancia (expresada por un número).

Los matemáticos de RUDN University realizaron cálculos y establecieron fórmulas que de mejor manera relacionan los valores de los pesos de las conexiones en una red antes y después de la cuantificación. Basándose en esto, construyeron algoritmos mediante los cuales, la red neuronal entrenada pudo clasificar las imágenes. En el experimento, los matemáticos usaron 50000 fotografías correspondientes a 1000 grupos. Después del entrenamiento, la red neuronal fue cuantificada utilizando el nuevo método, es decir, no se realizó el sobreajuste. Los resultados fueron comparados con los algoritmos de cuantificación existentes.

«Después de cuantificar, la precisión de la clasificación disminuyó, pero solo 1%. Al mismo tiempo, la cantidad de memoria necesaria se redujo seis veces. Los experimentos también demostraron que nuestra red neuronal no necesita entrenamiento posterior, esto se logró gracias a la fuerte correlación entre los pesos originales y los cuantificados. Este método permitirá ahorrar recursos al resolver ejercicios que requieran una ejecución rápida o al ponerlos en marcha en dispositivos móviles», explicó Iakov Karandashev, Doctor en Ciencias Físico-Matemáticas, profesor del Instituto Matemático S. M. Nikolskiy, RUDN University.

Los resultados fueron publicados en Optical Memory and Neural Networks.

Los productos derivados de las microalgas constituyen un avance en el campo de la bioeconomía. Las posibilidades de los biorrecursos se debatieron en el seminario internacional de investigación «Fundamentos para una energía verde sostenible»(«Foundations for a Green Sustainable Energy») en el marco del Grupo Temático Internacional «Energía» de la Universidad de Red BRICS. El evento fue organizado por el Instituto de Ecología de la RUDN.

El año 2024, en la RUDN empezó a admitirse las solicitudes de candidatura para el nuevo Premio anual a los logros científicos en el campo de la química. El premio se creó para reconocer las contribuciones a la investigación fundamental y aplicada, así como los méritos en la consecución de los Objetivos de Desarrollo Sostenible de la ONU.

Agrotecnólogo de la Universidad RUDN ha identificado genotipos de trigo que son resistentes a un patógeno fúngico peligroso que infecta las plantas incluso antes de que la nieve se derrita y reduzca los rendimientos.